- Entropía de Shannon

-

Entropía de Shannon

La entropía definida por Shannon, referida a la teoría de la información, hace referencia a la cantidad media de información que contiene una variable aleatoria o, en particular, una fuente transmisión binaria.

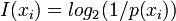

La información que aporta un determinado valor,

, de una variable aleatoria discreta

, de una variable aleatoria discreta  se define como:

se define como:

cuya unidad es el bit se utiliza el logaritmo en base 2 (por ejemplo, cuando se emplea el logaritmo neperiamo se habla de nats).

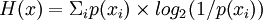

La entropía o información media de la variable aleatoria discreta,

, se determina como la información media del conjunto de valores discretos que puede adoptar (también medida en bits):

, se determina como la información media del conjunto de valores discretos que puede adoptar (también medida en bits):

Además de su definición y estudio, Shannon demostró analíticamente que la entropía es el límite máximo al que se puede comprimir una fuente sin ninguna pérdida de información.

Enlaces de Interés

Significado y origen de la fórmula de Shannon en serie de artículos sobre televisión digital Excelente

Categorías: Wikipedia:Fusionar | Teoría de la información

Wikimedia foundation. 2010.