- Entropía (información)

-

Entropía (información)

Entropía es un concepto en termodinámica, mecánica estadística y teoría de la información. Los conceptos de información y entropía están ampliamente relacionados entre sí, aunque se tardó años en el desarrollo de la mecánica estadística y la teoría de la información para hacer esto aparente. Este artículo versa sobre la entropía, en la formulación que hace de ella la Teoría de la información. Esta entropía se llama frecuentemente entropía de Shannon, en honor a Claude E. Shannon.

Contenido

Concepto básico

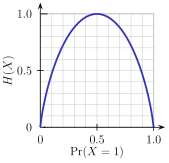

Entropía de la información en un ensayo de Bernoulli X (experimento aleatorio en que X puede tomar los valores 0 o 1). La entropía depende de la probabilidad P (X=1) de que X tome el valor 1. Cuando P (X=1)=0.5, todos los resultados posibles son igualmente probables, por lo que el resultado es poco predecible y la entropía es máxima.

Entropía de la información en un ensayo de Bernoulli X (experimento aleatorio en que X puede tomar los valores 0 o 1). La entropía depende de la probabilidad P (X=1) de que X tome el valor 1. Cuando P (X=1)=0.5, todos los resultados posibles son igualmente probables, por lo que el resultado es poco predecible y la entropía es máxima.

El concepto básico de entropía en teoría de la información tiene mucho que ver con la incertidumbre que existe en cualquier experimento o señal aleatoria. Es también la cantidad de "ruido" o "desorden" que contiene o libera un sistema. De esta forma, podremos hablar de la cantidad de información que lleva una señal.

Como ejemplo, consideremos algún texto escrito en español, codificado como una cadena de letras, espacios y signos de puntuación (nuestra señal será una cadena de caracteres). Ya que, estadísticamente, algunos caracteres no son muy comunes (por ejemplo, 'y'), mientras otros sí lo son (como la 'a'), la cadena de caracteres no será tan "aleatoria" como podría llegar a ser. Obviamente, no podemos predecir con exactitud cuál será el siguiente carácter en la cadena, y eso la haría aparentemente aleatoria. Pero es la entropía la encargada de medir precisamente esa aleatoriedad, y fue presentada por Shannon en su artículo de 1948 A Mathematical Theory of Communication ("Una teoría matemática de la comunicación", en inglés).

Shannon ofrece una definición de entropía que satisface las siguientes afirmaciones:

- La medida de información debe ser proporcional (continua). Es decir, el cambio pequeño en una de las probabilidades de aparición de uno de los elementos de la señal debe cambiar poco la entropía.

- Si todos los elementos de la señal son equiprobables a la hora de aparecer, entonces la entropía será máxima.

Ejemplos de máxima entropía : Suponiendo que estamos a la espera de un texto , por ejemplo un cable con un mensaje .En dicho cable solo se reciben las letras en minúscula de la (a hasta la z) , entonces si el mensaje que nos llega es "qalmnbphijcdgketrsfuvxyzwño" el cual posee una longitud de 27 caracteres , se puede decir que este mensaje llega a nosotros con la máxima entropía (o desorden posible) ya que es poco probable que se pueda pronosticar la entrada de caracteres ya que estos no se repiten y además no están ordenados en una forma predecible.

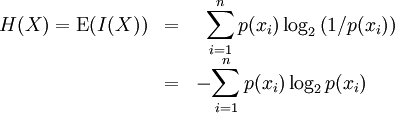

Definición formal

La entropía nos indica el límite teórico para la compresión de datos. También es una medida de la información contenida en el mensaje.

Su cálculo se realiza mediante la siguiente fórmula:

- Nota: La base del logaritmo dependerá de la variable con la que estemos trabajando, es decir, para una variable binaria usaremos la base 2, para una ternaria la base 3.

Explicación intuitiva

Una variable aleatoria X puede tomar distintos valores posibles en distintas repeticiones (realizaciones del experimento). Como algunos valores de X son más probables que otros, existe una distribución de probabilidad de los valores de X, la que depende del experimento elegido.

La entropía asociada a la variable X es un número que depende directamente de la distribución de probabilidad de X e indica lo plana que es esa distribución. Una distribución es plana (tiene alta entropía) cuando todos los valores de X tienen probabilidades similares, mientras que es poco plana cuando algunos valores de X son mucho más probables que otros. En una distribución de probabilidad plana (con alta entropía) es difícil poder predecir cuál es el próximo valor de X que va a presentarse, ya que todos los valores de X son igualmente probables.

Si a cada posible valor de X que pueda ocurrir se le asigna una cierta combinación de dígitos binarios 0 o 1 para diferenciarlo de los demás, la cantidad promedio de dígitos binarios que hay que asignarle a los distintos valores de X es (aproximadamente) igual a la entropía de la distribución de probabilidad de X. Los valores 0 o 1 usados suelen llamarse bits. Además, la metodología comúnmente usada para asignar combinaciones de valores 0 o 1 a los distintos valores posibles de X se conoce con el nombre de codificación Huffman.

Véase también

Categorías: Teoría de la información | Entropía de la información | Teoría estadística

Wikimedia foundation. 2010.