- Curva ROC

-

Curva ROC

Contenido

Curva ROC (Receiver Operating Characteristic)

Traducido y adaptado de los artículo de la wikipedia en inglés: operating characteristic analysis

Terminología y sus derivados

a partir de una matriz de confusión valign=top- Verdaderos Positivos (VP)

- o también éxitos

- Verdaderos Negativos (VN)

- o también rechazos correctos

- Falsos Positivos (FP)

- o también falsas alarmas o Error tipo I

- Falsos Negativos (FN)

- o también , Error de tipo II

- sensibilidad o Razón de Verdaderos Positivos (VPR)

- o también razón de éxitos y , recuerdo en recuperación de información,

- VPR = VP / V = VP / (VP + FN)

- Razón de Falsos Positivos (FPR)

- o también razón de falsas alarmas o fall-out en recuperación de información

- FPR = FP / N = FP / (FP + VN)

- Precisión o Exactitud (accuracy) (ACC)

- ACC = (VP + TN) / (P + N)

- Especificidad (SPC) or Razón de Verdaderos Negativos

- SPC = VN / N = VN / (FP + VN) = 1 − FPR

- Valor Predictivo Positivo (PPV)

- o también "precision" en recuperación de información

- PPV = VP / (VP + FP)

- Valor Predictivo Negativo (NPV)

- NPV = VN / (VN + FN)

- Razón de Falsos Descubrimientos(FDR)

- FDR = FP / (FP + VP)

Fuente: Fawcett, T. (2004): "ROC Graphs: Notes and Practical Considerations for Researchers". Technical report. Palo Alto, USA: HP Laboratories. http://home.comcast.net/~tom.fawcett/public_html/papers/ROC101.pdf

En la Teoría de detección de señales una curva ROC (acrónimo de Receiver Operating Characteristic, o Característica Operativa del Receptor ) es una representación gráfica de la sensibilidad frente a (1 – especificidad) para un sistema clasificador binario según se varía el umbral de discriminación. Otra interpretación de este gráfico es la representación de la razón de verdaderos positivos (VPR = Razón de Verdaderos Positivos) frente a la razón de falsos positivos (FPR = Razón de Falsos Positivos) también según se varía el umbral de discriminación (valor a partir del cual decidimos que un caso es un positivo). ROC también puede significar Relative Operating Characteristic (Característica Operativa Relativa) porque es una comparación de dos características operativas (VPR y FPR) según cambiamos el umbral para la decisión (3). En español es preferible mantener el acrónimo inglés, aunque es posible encontrar el equivalente español COR. No se suele utilizar ROC aislado, debemos decir “curva ROC” o “análisis ROC”. Sobre la historia del acrónimo ROC consultar Swets (1996).[1]El análisis de la curva ROC, o simplemente análisis ROC, proporciona herramientas para seleccionar los modelos posiblemente óptimos y descartar modelos subóptimos independientemente de (y antes de especificar) el coste de la distribución de las dos clases sobre las que se decide. La curva ROC es también independiente de la distribución de las clases en la población (en diagnóstico, la prevalencia de una enfermedad en la población). El análisis ROC se relaciona de forma directa y natural con el análisis de coste/beneficio en toma de decisiones diagnósticas.

La curva ROC se desarrolló por ingenieros eléctricos para medir la eficacia en la detección de objetos enemigos en campos de batalla mediante pantallas de radar, a partir de lo cual se desarrolla la Teoría de Detección de Señales (TDS). El análisis ROC se aplicó posteriormente en medicina, radiología, psicología y otras áreas durante varias décadas. Sólo recientemente ha encontrado aplicación en áreas como aprendizaje automático (o machine learning en inglés), y minería de datos (data mining en inglés).

Conceptos Básicos

Ver también: Error tipo I y tipo II

Un modelo de clasificación (clasificador o Clasificadores (matemático) o Diagnóstico) es una función que permite decidir cuáles de un conjunto de instancias están en un grupo o en otro. El resultado del clasificador o del diagnóstico puede ser un Número real (resultado continuo), en el que el límite del clasificador entre cada clase debe determinarse por un valor umbral, por ejemplo para determinar si una persona tiene hipertensión basándonos en una medida de presión arterial, o puede ser un resultado discreto que indica directamente una de las clases.

Consideremos un problema de predicción de dos clases o clasificación binaria, en la que los resultados se etiquetan como dos clases: positivos (p) o negativos (n). Hay cuatro posibles resultados a partir de un clasificador binario como el propuesto. Si el resultado de una predicción es p y el valor real es también p, entonces se conoce como un Verdadero Positivo (VP); sin embargo si el valor real es n entonces se conoce como un Falso Positivo (FP). De igual modo, tenemos un Verdadero Negativo (VN) cuando tanto la predicción como el valor real son n, y un Falso Negativo (FN) cuando el resultado de la predicción es n pero el valor real es p.

Un ejemplo aproximado de un problema real es el siguiente: consideremos una prueba diagnóstica que persiga determinar si una persona tiene una cierta enfermedad. Un falso positivo en este caso ocurre cuando la prueba predice que el resultado es positivo, cuando la persona no tiene realmente la enfermedad. Un falso negativo, por el contrario, ocurre cuando el resultado de la prueba es negativo, sugiriendo que no tiene la enfermedad cuando realmente sí la tiene.

Definamos un experimento a partir de P instancias positivas y N negativas. Los cuatro posibles resultados se pueden formular en una Tabla de contingencia 2x2, o Matriz de confusión, como sigue:

Valor en la realidad p n total Predicción

outcomep' Verdaderos

PositivosFalsos

PositivosP' n' Falsos

NegativosVerdaderos

NegativosN' total P N El espacio ROC

La tabla de contingencia puede proporcionar varias medidas de evaluación (ver caja de terminología). Para dibujar una curva ROC sólo son necesarias las razones de Verdaderos Positivos (VPR) y de falsos positivos (FPR). La VPR mide hasta qué punto un clasificador o prueba diagnóstica es capaz de detectar o clasificar los casos positivos correctamente, de entre todos los casos positivos disponibles durante la prueba. La FPR define cuántos resultados positivos son incorrectos de entre todos los casos negativos disponibles durante la prueba.

Un espacio ROC se define por FPR y VPR como ejes x e y respectivamente, y representa los intercambios entre verdaderos positivos (en principio, beneficios) y falsos positivos (en principio, costes). Dado que VPR es equivalente a sensibilidad y FPR es (1-especificidad), el gráfico ROC se llama a veces la representación de (1-especificidad) frente a la sensibilidad. Cada resultado de la predicción de una instancia de la matriz de confusión representa un punto en el espacio ROC.

El mejor método posible de predicción se situaría en un punto en la esquina superior izquierda, o coordenada (0,1) del espacio ROC, representando un 100% de sensibilidad (ningún falso negativo) y un 100% también de especificidad (ningún falso positivo). Este punto (0,1) es también llamado una clasificación perfecta. Por el contrario, una clasificación totalmente aleatoria (o adivinación aleatoria) daría un punto a lo largo de la línea diagnoal, que se llama también línea de no-discriminación, desde el extremo izquierdo hasta la esquina superior derecha. Un ejemplo típico de adivinación aleatoria sería decidir a partir de los resultados de lanzar una moneda al aire.

Curvas en el espacio ROC

Clasificadores discretos, como un Árbol de decisión o un conjunto de reglas, dan como resultados valores numéricos una etiqueta binaria. Cuando se usan estos clasificadores con un conjunto concreto de instancias para clasificar o predecir, el rendimiento del clasificador es un único punto en el espacio ROC. Para otros clasificadores, como un Clasificador bayesiano o una Red neuronal artificial, la salida son valores de probabilidad que representan hasta qué punto una instancia pertenece a una de las dos clases.

Para estos métodos, fijar un valor de umbral determinará un punto en el espacio ROC. Por ejemplo, si fijamos ese umbral en 0.8, la probabilidad de las instancias iguales o inferiores serán predichas como positivas, y los valores por debajo serán predichos como negativos. Por tanto podremos calcular una matriz de confusión para ese umbral de 0.8, y encontrar el punto correspondiente en el esapcio ROC. Según vamos variando el umbral (por ejemplo, en pasos de 0.1) tendríamos una nueva matriz de confusión y un nuevo punto en el espacio ROC. Dibujar la curva ROC consiste en poner juntos todos los puntos correspondientes a todos los umbrales o puntos de corte, de tal modo que ese conjunto de puntos se parecerá más o menos a una curva en el espacio cuadrado entre (0,0) y (1,1). Dependiendo del tipo de modelo la curva se parecerá más a una escalera (métodos no paramétricos) o una verdadera curva (métodos paramétricos).[2]

Cómo se puede interpretar una curva ROC

La curva ROC se puede usar para generar estadísticos que resumen el rendimiento (o la efectividad, en su más amplio sentido) del clasificador. A continuación se proporcionan algunos:

- El punto de intersección de la curva ROC con la línea perpendicular a la línea de no-discriminación.

- El área entre la curva ROC y la línea de no-discriminación.

- El área bajo la curva ROC, llamada comúnmente AUC (Area Under the Curve). También se puede encontrar denominada A' (pronunciado “a-prima”).

- Índice de sensibilidad o d' (d-prima, por cierto siempre minúscula). Es la distancia entre la media de la distribución de actividad en el sistema bajo condiciones de sólo rudio y su distribución bajo condiciones de sólo señal, dividido por su desviación típica, bajo el supuesto de que ambas distribuciones son normales con la misma desviación típica. Bajo estos supuestos, se puede probar que la forma de la curva ROC sólo depende de este parámetro d'.

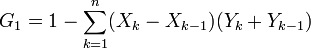

El indicador más utilizado en muchos contextos es el área bajo la curva ROC o AUC. Este índice se puede interpretar como la probabilidad de que un clasificador ordenará o puntuará una instancia positiva elegida aleatoriamente más alta que una negativa. Se puede demostrar que el área bajo la curva ROC es equivalente a la Prueba de Mann-Whitney, una prueba no paramétrica aplicada a dos muestras independientes, cuyos datos han sido medidos al menos en una escala de nivel ordinal. Se trata de una prueba estadística virtualmente idéntica a la realización de una prueba paramétrica ordinaria T de dos muestras en los datos después de haber ordenado las muestras combinadas. Es también equivalente a la Prueba de los signos de Wilcoxon. También se ha demostrado la relación del área bajo la curva ROC con el Coeficiente de Gini, con la siguiente fórmula G1 + 1 = 2xAUC, donde:

Otra forma básica de calcular AUC es usando un promedio de una serie de aproximaciones trapezoidales.

Sin embargo, se ha comentado que este indicador, en general, reducir la curva ROC a un único número, hace perder información sobre el patrón de intercambios del algoritmo discriminador en cuestión.

La comunidad de aprendizaje automático utiliza el estadístico AUC para la comparación de modelos. En otras áreas de ingeniería se prefiere la medida del área entre la curva ROC y la línea de no-discriminación. Finalmente en Psicofísica (preferible consultar la versión inglesa en [1]) se utiliza preferentemente d'.

La ilustración que abre este artículo muestra el uso de los gráficos ROC para la comparación de la capacidad predictiva de varios algoritmos predictivos basados en epitopes. Si quisieras descrubrir como mínimo el 60% de los epítopes en una proteína de un virus, se puede observar en el gráfico cómo alrededor de un tercio de los resultados estarían marcados erróneamente como epítopes. La información que no es visible en este gráfico es qué umbrales va a utilizar la persona que usa los algoritmos. En resumen: se trata de una medida pura de la eficacia o capacidad predictiva del sistema, independientemente del punto de corte que se utilice, de las reglas de las personas que usen los sistemas predictivos y también, y muy importante, de las tasas de verdaderos positivos en la población (o Prevalencia en contextos de diagnóstico médico).

En ocasiones puede ser más útil mirar a una región específica de la curva ROC más que a toda la curva. Es posible calcular áreas parciales bajo la curva, o AUC parciales. Por ejemplo, nos podríamos concentrar en la región de la curva con razones de falsos positivos más bajas, que es a menudo el interés principal de las pruebas de Detección precoz (o (medicine)|screening en la población.

Historia

La curva ROC se comenzó a utilizar durante la Segunda Guerra Mundial para el análisis de señales de radar, a partir de lo cual se desarrolló la Teoría de Detección de Señales. Después del ataque a Pearl Harbor en 1941, el ejército de los Estados Unidos comenzó un programa de investigación para detectar correctamente los aparatos japoneses a partir de sus señales de radar.

En los años 50, las curvas ROC se utilizaron en Psicofísica para evaluar la capacidad de detección de humanos (y también de no humanos) en señales débiles. En medicina el análisis ROC se ha utilizado de forma muy extensa en epidemiología e investigación médica, de tal modo que se encuentra muy relacionado con la Medicina basada en la evidencia. En Radiología, el análisis ROC es la técnica de preferencia para evaluar nuevas técnicas de diagnóstico por imagen.

Más recientemente, las curvas ROC se han mostrado muy útiles para la evaluación de técnicas de aprendizaje automático. La primera aplicación de las ROC en esta área fue por Spackman, quien demostró el valor de las curvas ROC para la comparación de diferentes algoritmos de clasificación.

Referencias

- ↑ Signal detection theory and ROC analysis in psychology and diagnostics : collected papers; Swets, 1996

- ↑ Concejero, Pedro (2004): Comparación de modelos de curvas ROC para la evaluación de procedimientos estadísticos de predicción en investigación de mercados. Tesis Doctoral. Universidad Complutense de Madrid. http://concejero.wikidot.com/tesis. http://concejero.wikidot.com/local--files/tesis/04-comparacion%20curvas%20ROC.pdf

- 1.^ Signal detection theory and ROC analysis in psychology and diagnostics : collected papers; Swets, 1996

- 2.^ J. Fogarty, R. Baker, S. Hudson (2005). "Case studies in the use of ROC curve analysis for sensor-based estimates in human computer interaction". ACM International Conference Proceeding Series, Proceedings of Graphics Interface 2005. Waterloo, Ontario, Canada: Canadian Human-Computer Communications Society.

- 3.^ Fawcett, T. (2006). An introduction to ROC analysis. Pattern Recognition Letters, 27, 861-874.

- 4.^ Hand, D.J., & Till, R.J. (2001). A simple generalization of the area under the ROC curve to multiple class classification problems. Machine Learning, 45, 171-186.

- 5.^ Hanley, JA; BJ McNeil (1983-09-01). "A method of comparing the areas under receiver operating characteristic curves derived from the same cases". Radiology 148 (3): 839–843. PMID 6878708. http://radiology.rsnajnls.org/cgi/content/abstract/148/3/839. Retrieved 2008-12-03.

- 6.^ McClish, Donna Katzman (1989-08-01). "Analyzing a Portion of the ROC Curve". Med Decis Making 9 (3): 190–195. doi:10.1177/0272989X8900900307. http://mdm.sagepub.com/cgi/content/abstract/9/3/190. Retrieved 2008-09-29.

- 7.^ Dodd, Lori E.; Margaret S. Pepe (2003). "Partial AUC Estimation and Regression". Biometrics 59 (3): 614–623. doi:10.1111/1541-0420.00071. http://www.blackwell-synergy.com/doi/abs/10.1111/1541-0420.00071. Retrieved 2007-12-18.

- 8.^ [1]

- 9.^ a b D.M. Green and J.M. Swets (1966). Signal detection theory and psychophysics. New York: John Wiley and Sons Inc.. ISBN 0-471-32420-5.

- 10.^ M.H. Zweig and G. Campbell (1993). "Receiver-operating characteristic (ROC) plots: a fundamental evaluation tool in clinical medicine". Clinical chemistry 39 (8): 561–577. PMID 8472349.

- 11.^ M.S. Pepe (2003). The statistical evaluation of medical tests for classification and prediction. New York: Oxford.

- 12.^ N.A. Obuchowski (2003). "Receiver operating characteristic curves and their use in radiology". Radiology 229 (1): 3–8. doi:10.1148/radiol.2291010898. PMID 14519861.

- 13.^ Spackman, K. A. (1989). "Signal detection theory: Valuable tools for evaluating inductive learning". Proceedings of the Sixth International Workshop on Machine Learning. San Mateo, CA: Morgan Kaufman. pp. 160–163.

Referencias generales

- T. Fawcett (2004). "ROC Graphs: Notes and Practical Considerations for Researchers". Technical report. Palo Alto, USA: HP Laboratories.

Otras referencias esenciales

- Zou KH, O'Malley AJ, Mauri L. (2007). Receiver-operating characteristic analysis for evaluating diagnostic tests and predictive models. Circulation, 6;115(5):654-7.

- Lasko, T.A., J.G. Bhagwat, K.H. Zou and Ohno-Machado, L. (2005). The use of receiver operating characteristic curves in biomedical informatics. Journal of Biomedical Informatics, 38(5):404-415.

- Balakrishnan, N., (1991) Handbook of the Logistic Distribution, Marcel Dekker, Inc., ISBN 978-0-8247-8587-1.

- Gonen M., (2007) Analyzing Receiver Operating Characteristic Curves Using SAS, SAS Press, ISBN: 978-1-59994-298-1.

- Green, W.H., (2003) Econometric Analysis, fifth edition, Prentice Hall, ISBN 0-13-066189-9.

- Hosmer, D.W. and Lemeshow, S., (2000) Applied Logistic Regression, 2nd ed., New York; Chichester, Wiley, ISBN 0-471-35632-8.

- Brown, C.D., and Davis, H.T. (2006) Receiver operating characteristic curves and related decision measures: a tutorial, Chemometrics and Intelligent Laboratory Systems, 80:24-38

- Mason, S.J. and Graham, N.E. (2002) Areas beneath the relative operating characteristics (ROC) and relative operating levels (ROL) curves: Statistical significance and interpretation. Q.J.R. Meteorol. Soc., 128:2145–2166.

- Pepe, M.S. (2003). The statistical evaluation of medical tests for classification and prediction. Oxford. ISBN 0-19-856582-8

- Carsten, S. Wesseling, S., Schink, T., and Jung, K. (2003) Comparison of Eight Computer Programs for Receiver-Operating Characteristic Analysis. Clinical Chemistry, 49:433-439

- Swets, J.A. (1995). Signal detection theory and ROC analysis in psychology and diagnostics: Collected papers. Lawrence Erlbaum Associates.

- Swets, J.A., Dawes, R., and Monahan, J. (2000) Better Decisions through Science. Scientific American, October:82-87

Enlaces externos

- Kelly H. Zou's Bibliography of ROC Literature and Articles

- A simple example of a ROC curve

- An introduction to ROC analysis

- A more thorough treatment of ROC curves and signal detection theory

- Diagnostic test evaluation - online calculator

- Tom Fawcett's ROC Convex Hull: tutorial, program and papers

- Peter Flach's tutorial on ROC analysis in machine learning

- The magnificent ROC — An explanation and interactive demonstration of the connection of ROCs to archetypal bi-normal test result plots

Wikimedia foundation. 2010.