- Divergencia de Kullback-Leibler

-

Divergencia de Kullback-Leibler

En teoría de la probabilidad la divergencia de Kullback-Leibler es un indicador de la similitud entre dos funciones de distribución. Dentro de la teoría de la información también se la conoce como divergencia de la información, ganancia de la información o entropía relativa.

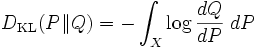

La divergencia de Kullback-Leibler entre dos funciones de distribución P y Q suele representarse así:

Se trata de una divergencia y no una métrica por no ser simétrica, es decir, no siempre se cumple que

Contenido

Formulación matemática

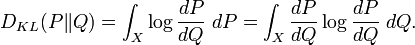

Si P es una medida de probabilidad es absolutamente continua con respecto a otra, Q, (condición necesaria para que

sea finito) y si

sea finito) y si  es la derivada de Radon–Nikodym de P con respecto a Q, se define la divergencia de Kulllback-Leibler desde P hasta Q de la forma

es la derivada de Radon–Nikodym de P con respecto a Q, se define la divergencia de Kulllback-Leibler desde P hasta Q de la forma ,

,

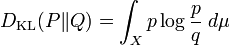

De la misma manera, si Q es absolutamente continua con respecto a P, entonces

Si ambas medidas son absolutamente continuas con respecto a una tercera medida μ, de forma que dP = pdμ y dQ = qdμ, entonces la fórmula anterior puede reescribirse de la siguiente manera:

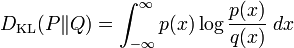

La divergencia de Kullback-Leibler no depende de la medida μ. Cuando esta medida es la de medida de Lebesgue sobre el eje real, resulta

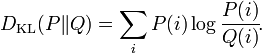

y cuando está concentrada sobre un conjunto discreto, se obtiene

Propiedades

- Es siempre positiva (puede probarse usando la desigualdad de Jensen).

- Es nula si y sólo si P = Q.

- No es simétrica (por lo que no se trata de una distancia).

Aplicaciones

Teoría de la información

Los logaritmos en estas fórmulas se toman en base 2 si la información se mide en unidades de bits, o en base e si la información se mide en nats. La mayoría de las fórmulas que involucran la divergencia de Kullback-Leibler son independientes de la base del logaritmo que se tome.

Estadística

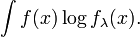

En estadística, la divergencia de Kullback-Leibler está íntimamente relacionada con el método de ajuste de distribuciones por máxima verosimilitud. En efecto, si se tienen observaciones x1,...,xn independientes de una variable aleatoria con función de densidad desconocida f y se tratan de ajustar dentro de una familia de funciones de densidad fλ, de acuerdo con la teoría de la máxima verosimilitud, se busca el parámetro λ que minimiza la función

Lλ = ∑ logfλ(xi), i que puede aproximarse (cuando n es grande) por

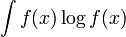

Restando dicha expresión del término constante

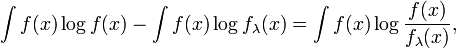

se obtiene

que es la divergencia de Kullback-Leibler entre fλ y la distribución verdadera determinada por f. Es decir, maximizar la función de verosimilitud es (aproximadamente) equivalente a encontrar el parámetro λ que minimiza la divergencia de Kullback-Leibler entre la distribución real y la familia de distribuciones parametrizadas por dicho parámetro.

Categorías: Teoría estadística | Entropía de la información | Probabilidad

Wikimedia foundation. 2010.