- Recursión de Levinson

-

Recursión de Levinson

La recursión de Levinson o de Levinson-Durbin es un algoritmo del álgebra lineal para calcular en forma recursiva la solución de una ecuación que involucra una matriz de Toeplitz. El costo computacional es de Θ(n2), una mejora considerable frente a la eliminación de Gauss-Jordan, cuyo costo es de Θ(n3).

Hay algoritmos nuevos, llamados asintóticamente rápidos o a menudo algoritmos de Toeplitz superrápidos, que pueden resolver con un costo de Θ(n logpn) para varios p (por ejemplo, para p = 2, p = 3). La recursión de Levinson sigue siendo popular por distintas razones; por un lado, es relativamente simple de comprender en comparación; por otro lado, puede ser más rápida que un algoritmo superrápido para n pequeño (normalmente para n < 256 [1]).

El algoritmo de Levinson-Durbin fue propuesto por primera vez por Norman Levinson en 1947, mejorado por J. Durbin en 1960 y más tarde mejorado a 4n2 y luego a 3n2 multiplicaciones por W. F. Trench y S. Zohar, respectivamente.

Otros métodos para procesar datos incluyen la descomposición de Schur y la descomposición de Cholesky. En comparación a estos, la recursión de Levinson (particularmente la recursión de Split-Levinson) tiende a ser más rápida computacionalmente, aunque más sensible a imperfecciones computacionales como errores de redondeo.

Contenido

Derivación

Contexto

Las ecuaciones matriciales tienen la siguiente forma:

El algoritmo de Levinson-Durbin puede usarse para tales ecuaciones, siempre y cuando M sea una matriz de Toeplitz conocida, con una diagonal principal no nula. En la ecuación,

es un vector conocido (en el sentido del álgebra lineal de lista de números) y

es un vector conocido (en el sentido del álgebra lineal de lista de números) y  es un vector de valores xi desconocidos y a ser determinados.

es un vector de valores xi desconocidos y a ser determinados.Llamaremos êi al vector compuesto de ceros, salvo en su i-ésimo lugar, que contiene el valor de la unidad. Su dimensión dependerá del contexto y estará implícita en éste. Con N nos referiremos al ancho de la matriz anterior, es decir, M es una matriz de N×N. Finalmente, los superindices se referirán a índices inductivos, mientras que subíndices denotarán simplemente índices. Por ejemplo, la matriz Tn es una matriz de n×n que copia el bloque superior izquierdo de n×n de M, es decir, Tnij = Mij.

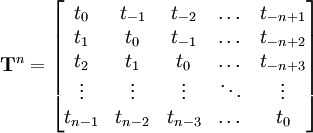

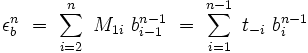

Tn también es una matriz de Toeplitz, en el sentido de que puede escribirse como:

Pasos introductorios

El algoritmo se desarrolla en dos pasos. En el primero, se establecen dos conjuntos de vectores, llamados vectores de avance y de retroceso. Los vectores de avance sirven para obtener el conjunto de vectores de retroceso y pueden luego ser descartados. Los vectores de retroceso son necesarios para el segundo paso, donde se los usa para construir la solución.

La recursión de Levinson-Durbin define el n-ésimo "vector de avance", denotado

, como el vector de longitud n que satisface:

, como el vector de longitud n que satisface:El n-ésimo "vector de retroceso"

se define de manera similar; es el vector de longitud n que satisface:

se define de manera similar; es el vector de longitud n que satisface:Una simplificación importante ocurre cuando M es una matriz simétrica: los dos vectores se relacionan mediante bni = fnn+1-i; es decir, uno se obtiene invirtiendo el order de los elementos del otro. Esto puede ahorrar cálculos extra en ese caso en particular.

Obtención del vector de retroceso

Incluso si la matriz no es simétrica, los n-ésimos vectores de avance y retroceso pueden encontrarse a partir de los vectores de longitud n-1 de la siguiente manera. Primero, el vector de avance puede extenderse con un cero para obtener:

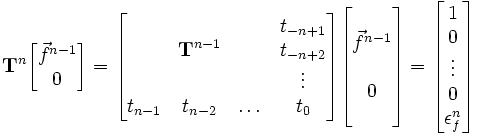

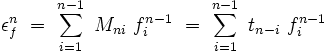

Al ir de Tn-1 a Tn, la columna extra agregada a la matriz no altera el resultado cuando se usa un cero para extender el vector de avance. Sin embargo, la fila extra agregada a la matriz sí lo altera, creando un error indeseado εf en el último lugar. De la ecuación anterior:

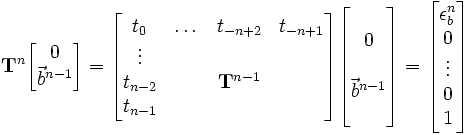

Volveremos a este error en un momento. Antes, extenderemos al vector de retroceso de manera similar (aunque invertida). Para el vector de retroceso:

Como antes, la columna extra agregada a la matriz no altera el resultado, pero sí lo hace la fila extra. Tenemos aquí, entonces, otro error indeseado εb, cuyo valor es:

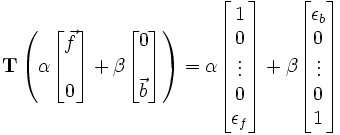

Podemos usar estos dos términos de error para eliminarlos en forma simultánea. Debido a la propiedad de linealidad de las matrices:

Si elegimos α y β de manera tal que el lado derecho dé como resultado ê1 o ên, entonces el valor entre paréntesis va a satisfacer la definición del vector de avance o retroceso n-ésimo, respectivamente. Con esos valores de α y β, la suma de vectores entre paréntesis es simple y da el resultado esperado.

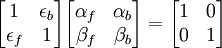

Para encontrar estos coeficientes, es decir, αf, βf, αb, y βb, nótese que todos los ceros en el medio de los dos vectores de arriba pueden ser ignorados y colapsados, dejando simplemente la ecuación:

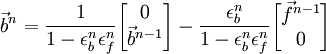

Resolviendo este sistema (por ejemplo, con la fórmula de inversa para matrices de 2x2), los nuevos vectores de avance y retroceso son:

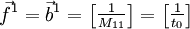

Realizando la suma de vectores, entonces, se obtienen los vectores de avance y retroceso n-ésimos, dados los anteriores. Lo único que resta es encontrar los vectores iniciales, para luego obtener los otros mediante simples sumas y multiplicaciones. Los vectores de avance y retroceso iniciales son simplemente:

Usando los vectores de retroceso

Los pasos anteriores dan los N vectores de retroceso para M. De ahí, una ecuación más arbitraria es:

La solución puede construirse de la misma manera iterativa en se construyeron los vectores de retroceso. Así,

debe generalizarse a la secuencia

debe generalizarse a la secuencia  , de la cual

, de la cual  .

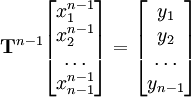

.La solución se construye entonces de manera iterativa, notando que si:

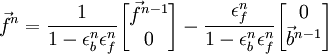

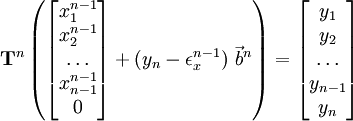

Entonces, extendiendo con un cero nuevamente, y definiendo una constante de error donde corresponda:

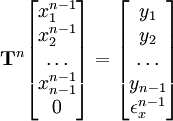

Podemos usar entonces el vector de retroceso n-ésimo para eliminar el término de error y reemplazarlo con la fórmula deseada de la siguiente manera:

Extendiendo este método hasta n = N se obtiene la solución

.

.En la práctica, estos pasos se hacen a menudo en forma concurrente con el resto del procedimiento, pero forman una unidad coherente y merecen ser tratados como pasos separados.

Referencias

- Levinson, N. (1947). "The Wiener RMS error criterion in filter design and prediction," J. Math. Phys., v. 25, pp. 261-278.

Véase también

- Recursión de Split-Levinson

- Predicción lineal

Categorías: Matrices | Análisis numérico

Wikimedia foundation. 2010.